思维链提示综合指南-CoT

什么是提示工程?

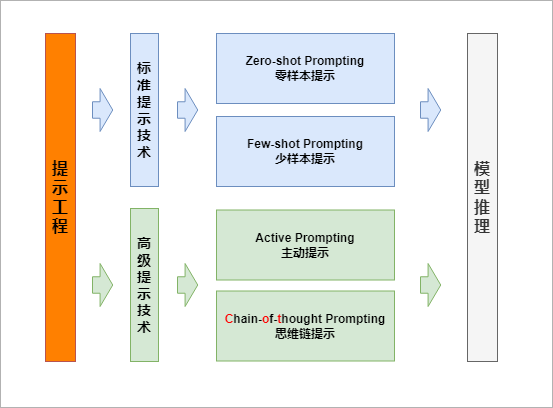

提示工程是

编写结构良好且精心制作的提示的实践,这些提示可以通过生成式 AI 模型更好地解释。

- 提示告诉 LLM 要执行什么任务以及要生成什么样的输出。它可以包含

指令、上下文、输入数据和输出指示器。- 使用提示工程,我们可以使用 LLM 来执行各种任务,从简单的问答到复杂的创意文本生成。

- 它基于一个涌现属性,即上下文学习,允许 LLM 从提示中学习。提示工程提高了 LLM 在手头任务上的性能。如前所述,它使用

零样本、少样本、主动和CoT提示。

Zero-shot Prompting 零样本提示

关注后解锁

Few-shot Prompting 少样本提示

关注后解锁

Active Prompting 主动提示

关注后解锁

什么是思维链提示?

关注后解锁

参考资料

限制

CoT 推理是 LLM 的一种涌现能力,可能是由于将模型扩展到 1000 亿个参数以上而产生的。它不会对较小的 LLM 的性能产生积极影响,只有在与这种规模的模型一起使用时才会产生性能提升。

这有两个原因。

- 首先,较小的 LLM 无法产生既流畅又合乎逻辑的长链思维。这会导致性能低于标准提示。

- 其次,CoT推理对于更复杂的问题更有效。它要求LLM能够确定解决问题所涉及的关键步骤,然后产生导致解决方案的思维链。较小的 LLM 可能无法像较大的 LLM 那样有效地做到这一点。

CoT推理在大型LLM中出现的另一个原因可能是由于它们的预训练数据。较大的 LLM 通常在包含分步推理的海量数据集上进行训练,这可以帮助他们发展以思维链方式推理的能力。

- 对于CoT功能来说,指令遵循似乎不是必需的,因为

零样本和少样本CoT推理是使用未经微调以遵循指令的LLM进行的。- 然而,指令遵循可能会提高 CoT 推理的质量。最终,需要更多的研究来确定大型LLM中出现CoT推理的确切原因。

根据Wei等人的说法,“

思维链仅在使用∼100B参数的模型时才会产生性能提升”。较小的模型编写了不合逻辑的思维链会导致精度比标准提示更差。通常,模型从思维链提示过程中获得性能提升的方式与模型的大小成比例。论文地址:https://arxiv.org/abs/2201.11903